Principal Component Analysis und Principal Component Regression, (PCA und PCR)

Die Hauptkomponentenanalyse geht von der Annahme aus, dass es bei stark korrelierten Größen eine dritte Größe gibt, die nicht direkt messbar ist und die hinter diesen korrelierten Variablen steht und sich quasi in ihnen äußert. Das bedeutet, die messbaren Größen sind nur eine andere Erscheinungsform von Größen, die im Hintergrund stehen und nicht direkt gemessen werden können. Man nennt diese im Hintergrund stehenden Größen Hauptkomponenten (Principal Components), Latent Variables oder Faktoren. Ziel der Hauptkomponentenanalyse ist es, solche Hintergrundgrößen bzw. Faktoren aus den gemessenen Daten zu ermitteln und die beobachteten Zusammenhänge möglichst vollständig zu erklären. Mit Hilfe der Hauptkomponentenanalyse lassen sich demzufolge komplexe Informationen auf nur wenige, orthogonale Informationen verdichten.

Die Hauptkomponentenanalyse bestimmt die Faktoren nach rein mathematischen Gesichtspunkten. Da der erste Faktor immer in die Richtung der maximalen Varianz in den Daten zeigt, werden dadurch die real gemessen Informationen am besten repräsentiert. Der zweite Faktor muss darauf senkrecht stehen und die nächstgrößte Varianz erklären und so weiter. Dies hat den Vorteil, dass man ein orthogonales Koordinatensystem erhält, in dem die Objekte beschrieben werden (Scoreplot). Die Gewichtswerte (Scores) jedes Objekts werden grafisch als sogenannter “Loadingplot“ dargestellt. Dieser enthält die Gewichtung jeder einzelnen Variablen des Originaldatenraums für die entsprechende Hauptkomponente.

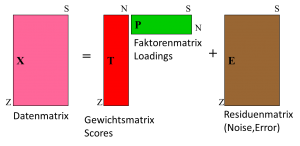

In der mathematischen Formulierung der Hauptkomponentenanalyse wird der zu untersuchende Datensatz X als das Produkt einer möglichst kleinen Anzahl von Hauptkomponenten P und Gewichtsvektoren T dargestellt. Man beschreibt also folgende Zerlegung:

Abbildung: Visualisierung der Hauptkomponentenanalyse

Wobei in E alle Fehler zusammengefasst werden oder der nicht-interpretierbare Teil der Information.

Zusammengefasst erhält man folgende Informationen:

- Hauptkomponenten (Principal Components), sie beinhalten die Haupt-veränderungen der Daten und werden auch Latente Variable, Faktoren oder Eigenvektoren genannt

- Loadings geben die Zahlenwerte der neuen Hauptachsen (Koordinatenachsen) an, die für den Datensatz berechnet werden

- Scores, sind die Koordinatenwerte für jedes einzelne Objekt bezogen auf die neuen Hauptachsen

Man kann die Ergebnisse der Hauptkomponentenanalyse folgendermaßen zusammenfassen:

- Datenreduktion und Vereinfachung

- Datenmodellierung

- Erkennen von Ausreißern

- Auswahl von Variablen (variable selection)

- Klassifizierung der Objekte

- Vorhersage

- „Entmischen“ von Informationen (curve resolution)

Durch Drehen der nunmehr neuen Koordinaten kann die orthogonale Information aber auch auf Zielgrößen wie Qualitätskenngrößen abgebildet werden (Partial Least Squares, PLS, siehe unten). Damit erhält man bessere Korrelationen als durch die lineare Kombination der Faktoren, die durch die PCA ermittelt werden (Principal Component Regression, PCR). Allerdings besteht bei diesen Methoden die Gefahr von nicht-kausalen Regressionsmodellen. Diese Gefahr wird jedoch minimiert, wenn gleichzeitig Wissen in die multivariate Auswertung integriert wird (siehe Multivariate Curve Resolution, MCR).

Partial Least Square Regression (PLS)

Die Methode der PLS berechnet eine Regression von vielen unabhängigen x-Variablen auf eine oder mehrere y-Variablen. Der Unterschied zur Multilinearen Regression ist der, dass die x-Variablen hoch korreliert und interkorreliert sein dürfen. Auch können es viel mehr x-Variable als Objekte geben und trotzdem kann die Regression berechnet werden.

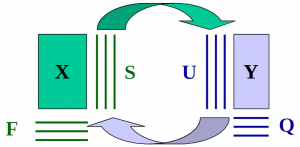

Auch bei der PLS Regression werden die x-Variablen in die Matrizen S und F zerlegt, wie bei der PCA. Allerdings wird bei dieser Zerlegung in die Hauptkomponenten für x die Zielgröße y schon mit einbezogen.